AMD vs Nvidia au CES 2026 : Deux approches différentes des puces IA

AMD et Nvidia ont profité du CES 2026 pour redéfinir le champ de bataille des puces IA. Alors qu’AMD pousse l’IA partout, des PC à l’edge embarqué, Nvidia mise sur les superordinateurs IA full-stack pour les hyperscalers.

Nvidia (NVDA) se négocie près du sommet de sa fourchette sur 52 semaines, entre le haut des 180 $ et le bas des 190 $, après une année 2025 portée par la demande de GPU pour data-centres et les investissements IA des hyperscalers. AMD (AMD) affiche une progression d’environ 70 % sur un an, mais reste valorisée à un niveau inférieur à NVDA en termes de ratio cours/ventes, même si les investisseurs la considèrent de plus en plus comme une « bêta IA avec potentiel de rattrapage ».

AMD : « L’IA partout » du PC à l’accélérateur

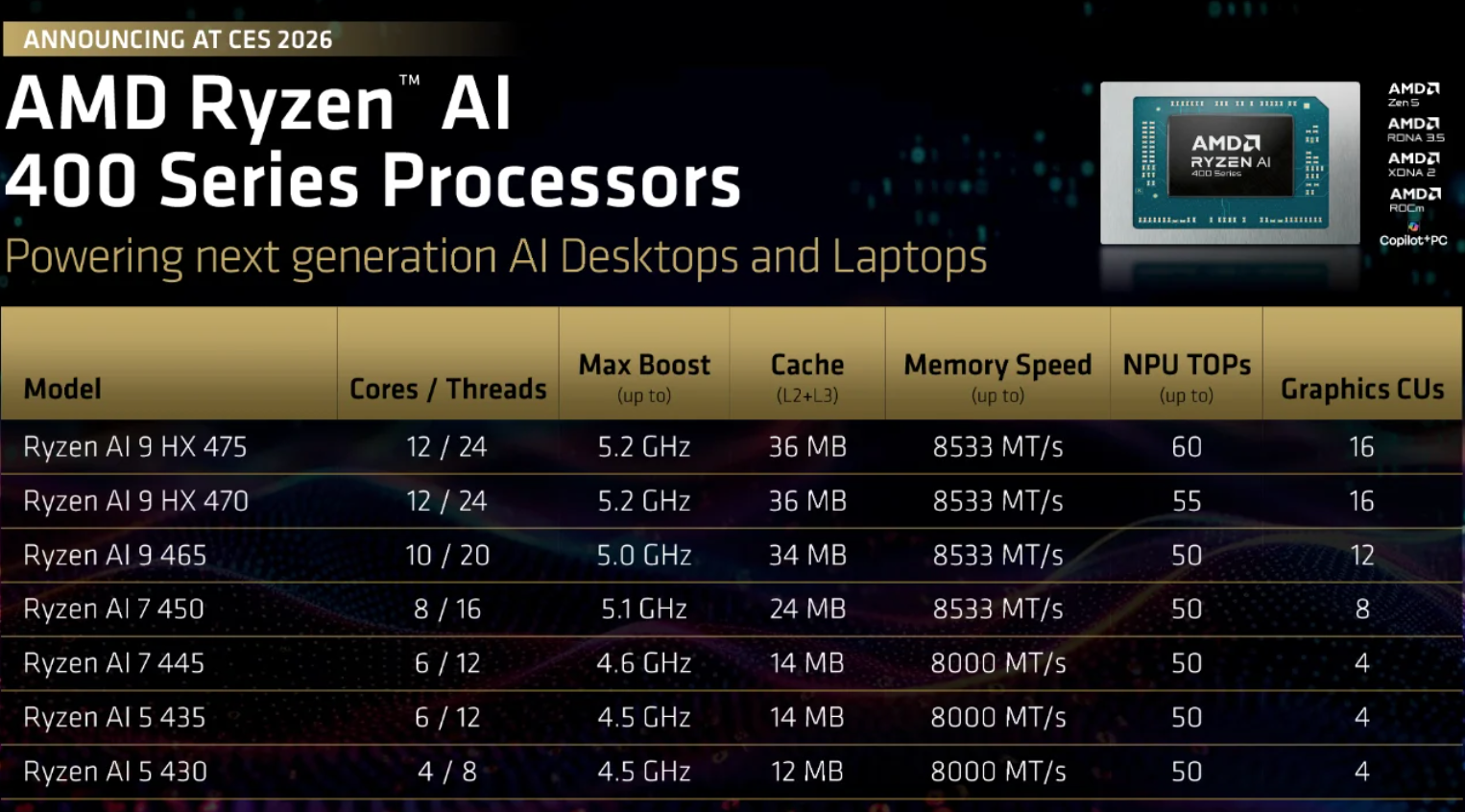

Au CES, AMD a élargi sa gamme Ryzen AI avec les nouvelles puces pour ordinateurs portables Ryzen AI 400 / AI Max+, ainsi qu’une nouvelle ligne Ryzen AI Embedded basée sur Zen 5, ciblant l’automobile, l’industrie et les déploiements d’« IA physique ». La direction présente explicitement la base installée de PC comme un edge IA distribué, avec des conceptions OEM attendues en montée en puissance tout au long de 2026.

Côté data-centre, AMD étend sa feuille de route des accélérateurs MI300/MI455, positionnant ces GPU comme des alternatives plus ouvertes et moins coûteuses à Nvidia pour l’entraînement et l’inférence à grande échelle, en visant notamment des clients de type OpenAI comme adopteurs réalistes. Pour les desks de trading, AMD apparaît comme une classique « histoire de gain de parts de marché » : base installée plus petite, mais effet de levier opérationnel significatif si ROCm, les victoires de la série MI et les taux d’adoption de Ryzen AI se concrétisent.

Nvidia : mise sur les superordinateurs IA

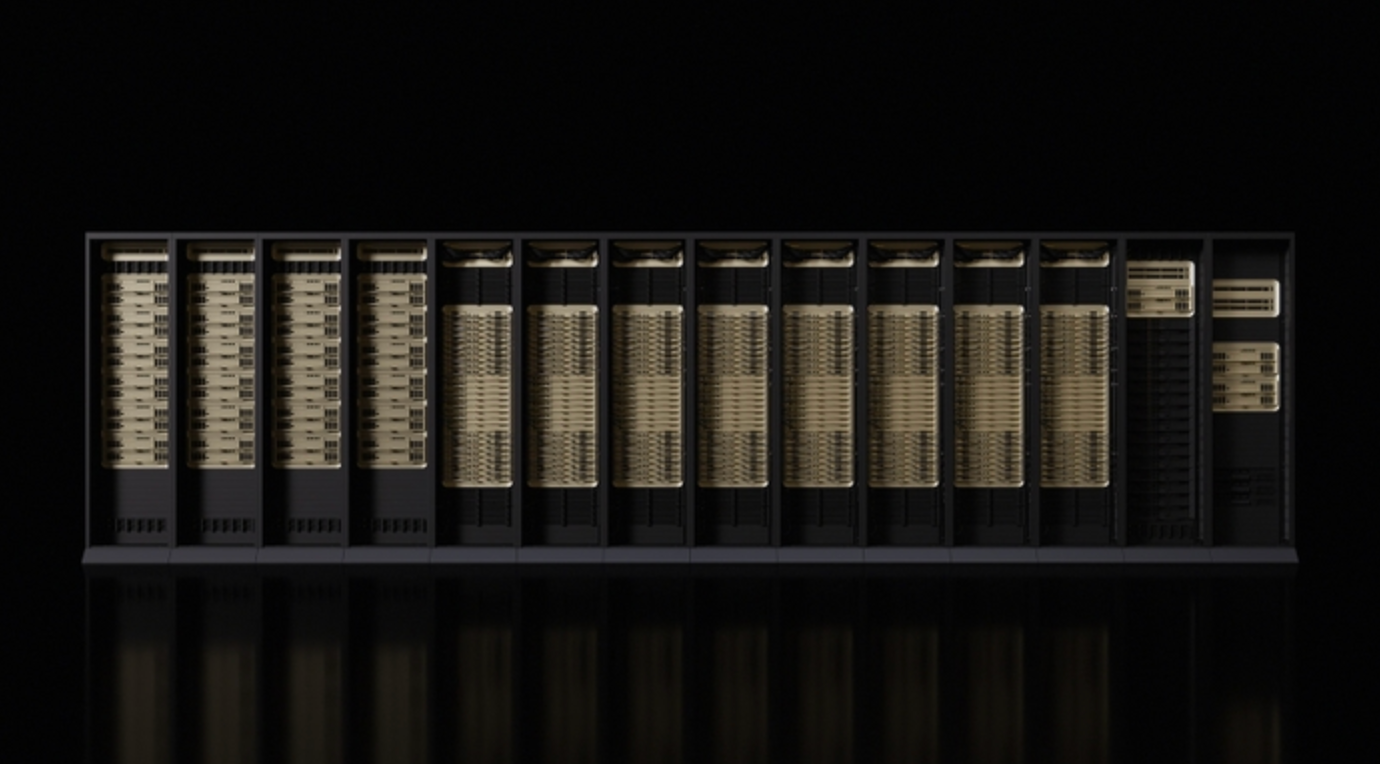

Nvidia a répondu avec la plateforme Rubin – six nouvelles puces, dont les GPU Rubin, les CPU Vera et les réseaux NVLink 6 / Spectrum‑X mis à jour, vendus comme une pile superordinateur IA clé en main.

Rubin vise explicitement les « usines IA » pour les modèles avancés et les workloads agentiques, avec les premiers systèmes attendus au second semestre 2026.

Point crucial, Rubin est déployé avec les quatre principaux hyperscalers (AWS, Azure, Google Cloud, Oracle Cloud) ainsi que des clouds GPU spécialisés, renforçant le rôle central de Nvidia dans les dépenses d’infrastructure IA. D’un point de vue trading, NVDA reste l’indice IA de facto : valorisé de façon élevée, mais soutenu par des investissements cloud pluriannuels ; tout basculement visible vers des ASICs sur mesure ou un ralentissement des budgets IA constitue le principal risque pour le multiple actuel.

Pourquoi c’est important

Le CES 2026 a souligné que le trade IA entre dans une phase plus exigeante. Le récit facile – « IA égale GPU égale hausse » – s’estompe. Ce qui compte désormais, c’est où les workloads IA s’installent réellement, la durabilité des dépenses d’investissement, et quels fournisseurs conservent leur pouvoir de fixation des prix alors que l’inférence, l’efficacité et le déploiement deviennent centraux.

La stratégie de Nvidia renforce sa position au cœur des budgets IA des hyperscalers, mais cette concentration comporte des risques. À mesure que l’entraînement arrive à maturité et que l’inférence s’étend, les marges risquent de se comprimer et la concurrence – d’AMD, du silicium sur mesure et des alternatives cloud-native – va s’intensifier. Le risque d’exécution augmente alors que les valorisations restent élevées.

AMD, à l’inverse, mise sur la largeur plutôt que la domination. Son approche « IA partout » la positionne pour profiter si l’adoption de l’IA s’étend au-delà des data-centres géants vers les PC, les systèmes industriels et les usages embarqués. Pour les marchés, cela fait d’AMD moins un leader incontesté qu’un acteur de la capture incrémentale de parts sur une surface IA en expansion.

En résumé, le CES a confirmé que l’IA n’est plus une histoire de trade unique. La prochaine étape sera dictée par l’économie des déploiements, et non plus seulement par l’ambition de calcul.

Lecture stratégique pour le trade des puces IA

Le CES 2026 confirme qu’aucun des deux fournisseurs ne vend plus de simples puces ; tous deux livrent des plateformes – silicium, interconnexion, écosystèmes logiciels (CUDA vs. ROCm) et systèmes de référence.

Pour les investisseurs, les questions centrales sont désormais : qui capte les workloads hyperscaler incrémentaux, quel pouvoir de fixation des prix subsiste alors qu’AMD, le silicium sur mesure et la pression réglementaire montent, et quelle est la résilience du capex IA lors du prochain ralentissement macroéconomique.

Dans ce cadre, Nvidia reste l’exposition cœur IA infrastructurelle à forte conviction, tandis qu’AMD offre un potentiel de hausse plus élevé (bêta) si sa stratégie « IA partout » se traduit par de réels gains de parts dans les accélérateurs et l’IA PC/edge sur les 12 à 24 prochains mois.

À retenir

Le CES 2026 a mis en lumière une divergence stratégique nette. Selon les analystes, Nvidia est un pari système à forte conviction sur l’infrastructure IA des hyperscalers, mais avec une sensibilité croissante à l’économie de l’inférence, à la pression sur les prix et aux conditions macroéconomiques. AMD offre un potentiel de hausse plus élevé via sa volonté d’intégrer l’IA dans les PC, les appareils edge et les piles d’accélérateurs alternatifs – une voie plus risquée, mais avec un effet de levier significatif si l’adoption s’élargit sur les 12 à 24 prochains mois.

Pour les investisseurs et les traders, le trade des puces IA évolue d’une histoire de momentum vers un trade de sélectivité, où la fidélité à la plateforme, l’efficacité des coûts et la composition des workloads comptent autant que la performance brute.

Perspectives techniques AMD et Nvidia

AMD se stabilise après un repli volatil depuis les sommets à 260 $, avec un prix qui consolide autour de la zone des 223 $ alors que les acheteurs reviennent prudemment. Bien que la structure globale reste en range, la dynamique s’améliore : le RSI progresse régulièrement au-dessus de la médiane, signalant une reprise graduelle de la conviction haussière plutôt qu’un rebond brutal de prise de risque.

D’un point de vue structurel, le support à 187 $ reste un niveau clé à la baisse, une cassure en dessous risquant de déclencher des ventes forcées, tandis que la zone plus profonde des 155 $ marque un support de tendance à plus long terme.

À la hausse, la résistance à 260 $ continue de limiter la reprise, ce qui signifie qu’AMD aura besoin d’une pression d’achat soutenue pour confirmer une nouvelle tendance haussière. Pour l’instant, l’action des prix suggère une consolidation avec un léger biais haussier, plutôt qu’une cassure décisive.

NVIDIA tente de se stabiliser après son récent repli, avec un prix qui repasse la zone des 189 $ et revient vers le milieu de sa fourchette plus large. Le rebond depuis la zone de support à 170 $ a amélioré la structure à court terme, tandis que la dynamique commence à devenir constructive : le RSI grimpe nettement juste au-dessus de la médiane, signalant un regain d’intérêt acheteur plutôt qu’un simple rebond technique.

Cela dit, la progression à la hausse reste limitée par la résistance à 196 $ et le niveau clé des 208 $, où les précédents rallyes ont déclenché des prises de bénéfices. Tant que NVDA reste au-dessus de 170 $, la structure globale reste intacte, mais il faudra une cassure durable au-dessus de 196 $ pour confirmer une poursuite haussière plus solide.

Les performances passées ne préjugent pas des performances futures.